一、概述

背景和定义

1)HDFS产生背景

随着数据量越来越大,在一个操作系统存不下所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。HDFS只是分布式文件管理系统中的一种。

2)HDFS定义

HDFS(Hadoop Distributed File System),它是一个文件系统,用于存储文件,通过目录树来定位文件;其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS的使用场景:适合一次写入,多次读出的场景。一个文件经过创建、写入和关闭之后就不需要改变。

优缺点

HDFS优点

1)高容错性

- 数据自动保存多个副本。它通过增加副本的形式,提高容错性。

- 某一个副本丢失以后,它可以自动恢复。

2)适合处理大数据

- 数据规模:能够处理数据规模达到GB、TB、甚至PB级别的数据;

- 文件规模:能够处理百万规模以上的文件数量,数量相当之大。

3)可构建在廉价机器上,通过多副本机制,提高可靠性。

HDFS缺点

1)不适合低延时数据访问,比如毫秒级的存储数据,是无法实现的。

2)无法高效的对大量小文件进行存储。

- 存储大量小文件,会占用NameNode大量的内存来存储文件目录和块信息。

- 小文件存储的寻址时间会超过读取时间,违反了HDFS的设计目标。

3)不支持并发写入、文件随机修改。

- 一个文件只能有一个写,不允许多个线程同时写。

- 仅支持数据追加(append),不支持文件的随机修改。

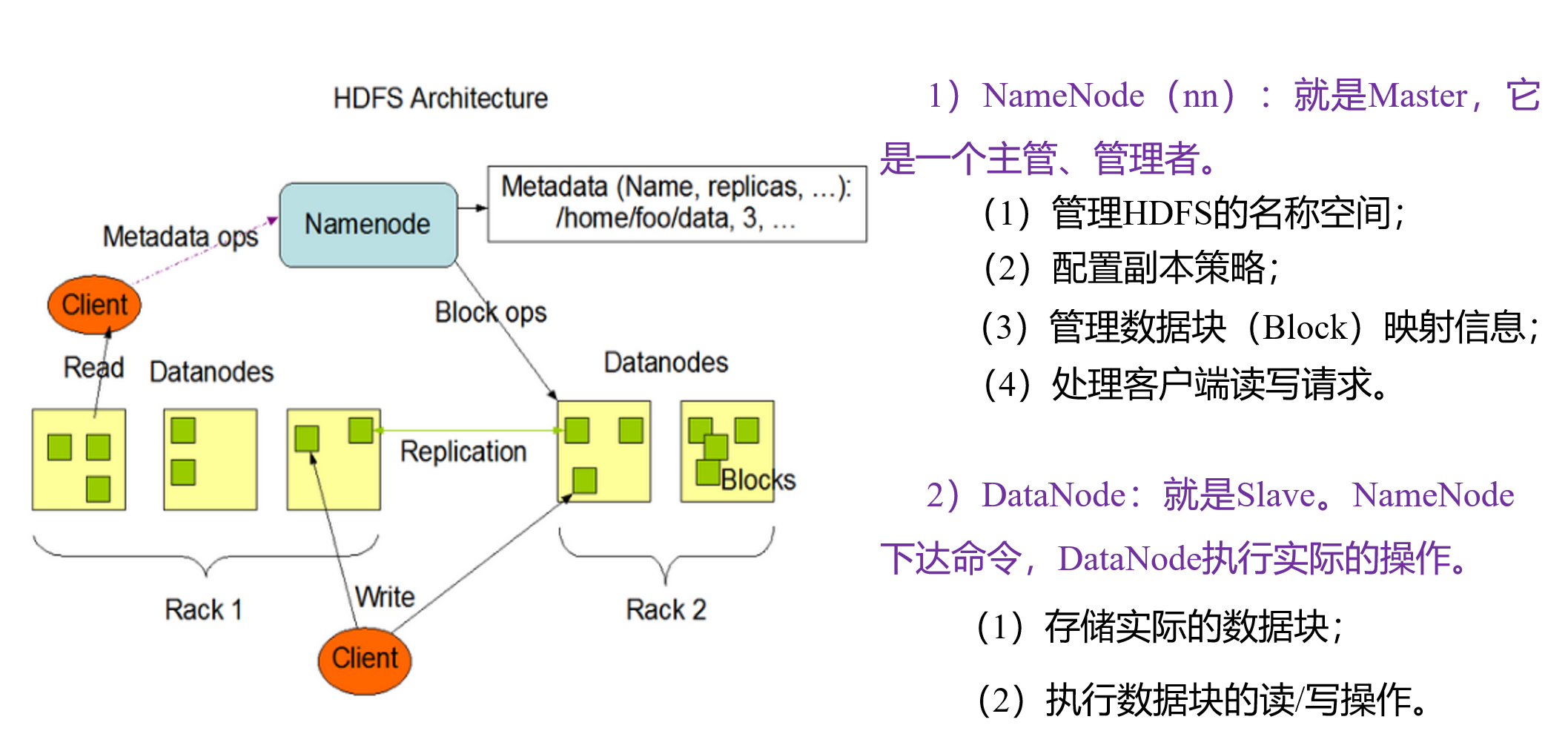

组成

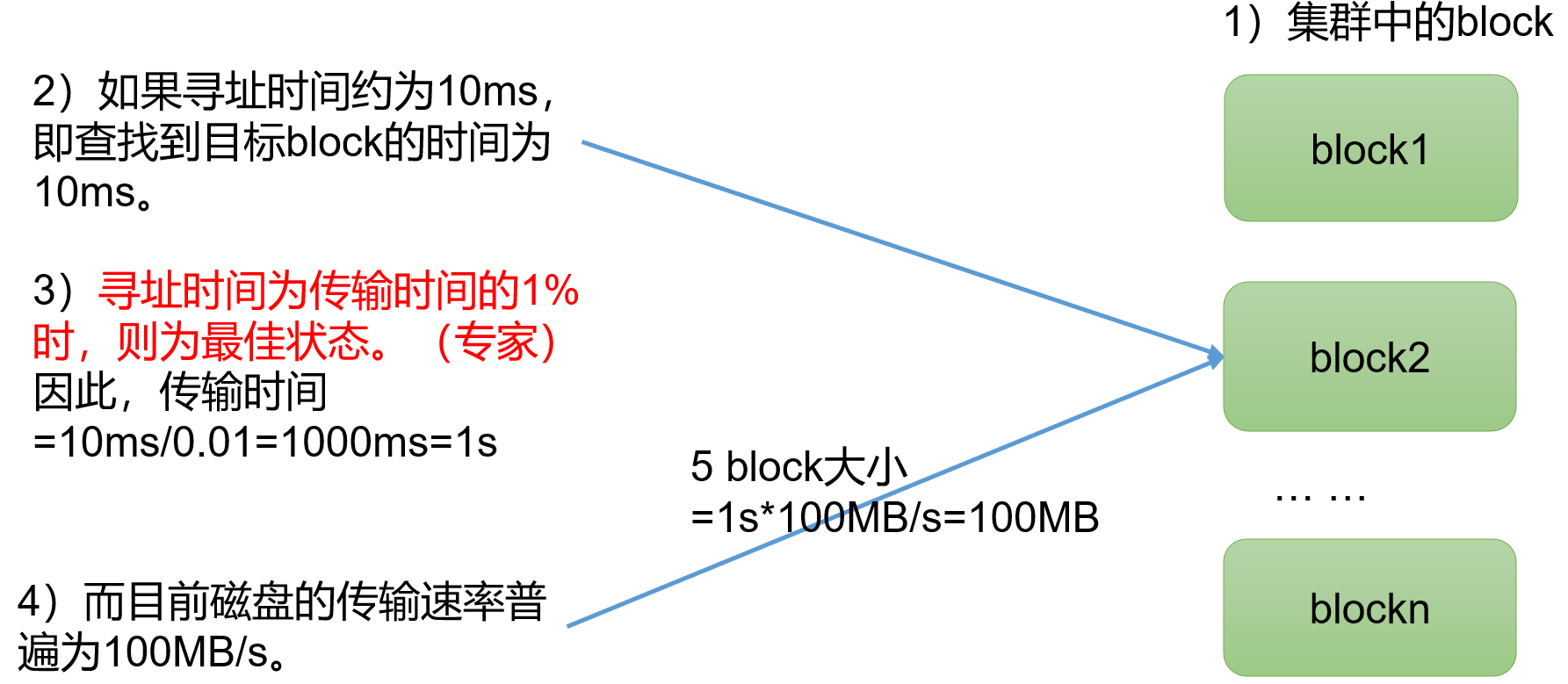

HDFS文件块大小

HDFS中的文件在物理上是分块存储(Block),块的大小可以通过配置参数(dfs.blocksize)来规定,默认大小在Hadoop2.x/3.x中是128M,1.x版本是64M。

二、Shell相关操作

基本语法

hadoop fs具体命令 或者 hdfs dfs命令,两个是完全相同的。

命令大全

准备命令

1)启动Hadoop集群

[root@node50 hadoop]# sbin/start-dfs.sh

[root@node50 hadoop]# sbin/start-yarn.sh2)-help:输出命令参数

[root@node50 hadoop]# hadoop fs -help rm3)创建文件夹

[root@node50 hadoop]# hadoop fs -mkdir /testM上传

1)-moveFromLocal:从本地剪切粘贴到HDFS

[root@node50 hadoop]# hadoop fs -moveFromLocal ./wenjian.txt /testM2)-copyFromLocal:从本地拷贝到HDFS

[root@node50 hadoop]# hadoop fs -copyFromLocal wenjian.txt /testM3)-put:等同于copyFromLocal,生产环境更多使用put

[root@node50 hadoop]# hadoop fs -put wenjian.txt /testM4)-appendToFile:追加一个文件到已经存在的文件末尾

[root@node50 hadoop]# hadoop fs -appendToFile appendFile.txt /testM/wenjian.txt下载

1)-copyToLocal:从HDFS拷贝到本地

[root@node50 hadoop]# hadoop fs -copyToLocal /testM/wenjian.txt ./2)-get:等同于copyToLocal,生产环境更多使用get

[root@node50 hadoop]# hadoop fs -get /testM/wenjian.txt ./hdfs直接操作

1)-ls:显示目录信息

[root@node50 hadoop]# hadoop fs -ls /testM2)-cat:显示文件内容

[root@node50 hadoop]# hadoop fs -cat /testM/wenjian.txt3)-chgrp、-chmod、-chown:修改文件所属权限

[root@node50 hadoop]# hadoop fs -chmod 666 /testM/wenjian.txt4)-mkdir:创建路径

[root@node50 hadoop]# hadoop fs -mkdir /newFile5)-cp:从hdfs的一个路径拷贝到hdfs另一个路径

[root@node50 hadoop]# hadoop fs -cp /testM/wenjian.txt /newM6)-mv:在hdfs中移动文件

[root@node50 hadoop]# hadoop fs -mv /testM/wenjian.txt /newFile7)-tail:显示一个文件的末尾1kb的数据

[root@node50 hadoop]# hadoop fs -tail /testM/wenjian.txt8)-rm:删除文件或文件夹

[root@node50 hadoop]# hadoop fs -rm /testM/wenjianDel.txt9)-rm -r:递归删除目录及目录里面内容

[root@node50 hadoop]# hadoop fs -rm -r /newFile10)-du统计文件夹的大小信息

[root@node50 hadoop]# hadoop fs -du -s -h /testM

22 81 /testM说明:22表示文件大小;81表示27*3个副本;/testM表示查看的目录

11)-setrep:设置HDFS中文件的副本数量

[root@node50 hadoop]# hadoop fs -setrep 10 /testM/wenjian.txt说明:这里设置的副本数只是记录在NameNode的元数据中,是否真的会有这么多副本,还得看DataNode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10。

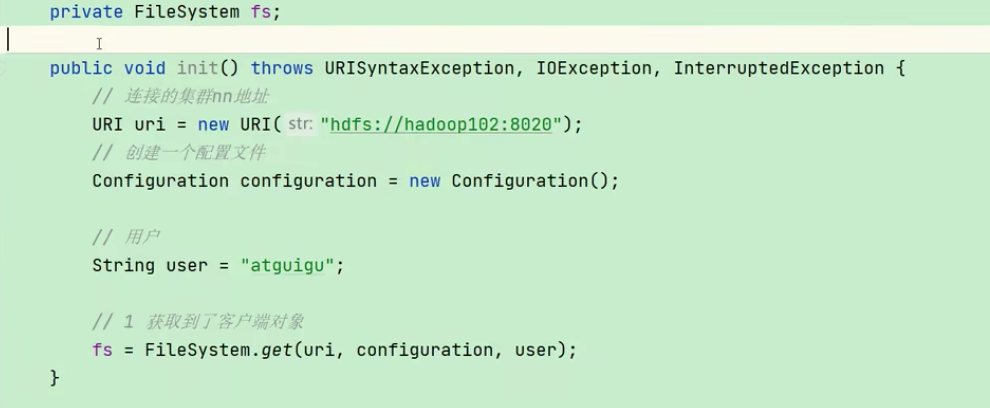

三、客户端API

数据的上传和下载

创建目录

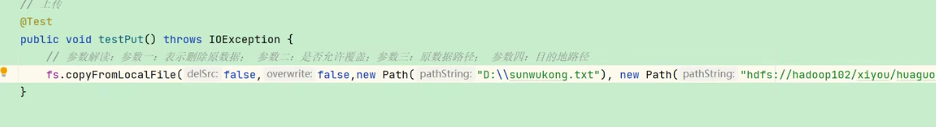

文件上传

文件下载

文件删除

文件更名和移动

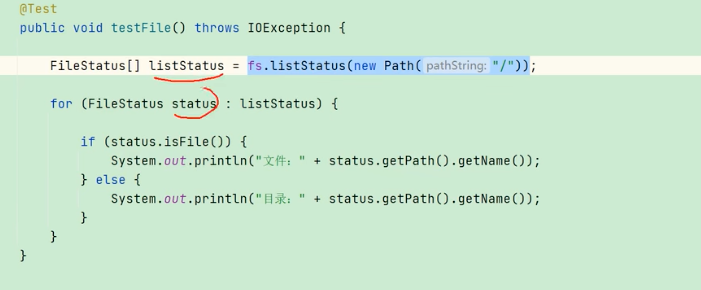

文件详情查看

文件和文件夹的判断

四、读写流程

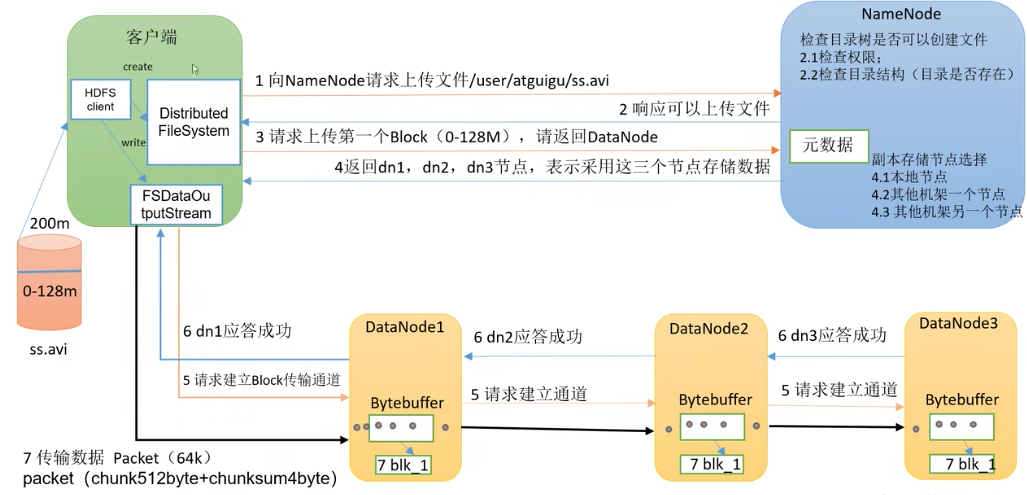

写数据流程

(1)客户端通过Distributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否已存在,父目录是否存在。

(2)NameNode返回是否可以上传。

(3)客户端请求第一个Block上传到哪几个DataNode服务器上。

(4)NameNode返回3个DataNode节点,分别为dn1、dn2、dn3。

(5)客户端通过FSDataOutputStream模块请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成。

(6)dn1、dn2、dn3逐级应答客户端。

(7)客户端开始往dn1上传第一个Block(先从磁盘读取数据放到一个本地内存缓存),以Packet为单位,dn1收到一个Packet就会传给dn2,dn2传给dn3;dn1每传一个packet会放入一个应答队列等待应答。

(8)当一个Block传输完成之后,客户端再次请求NameNode上传第二个Block的服务器。(重复执行3-7步)。

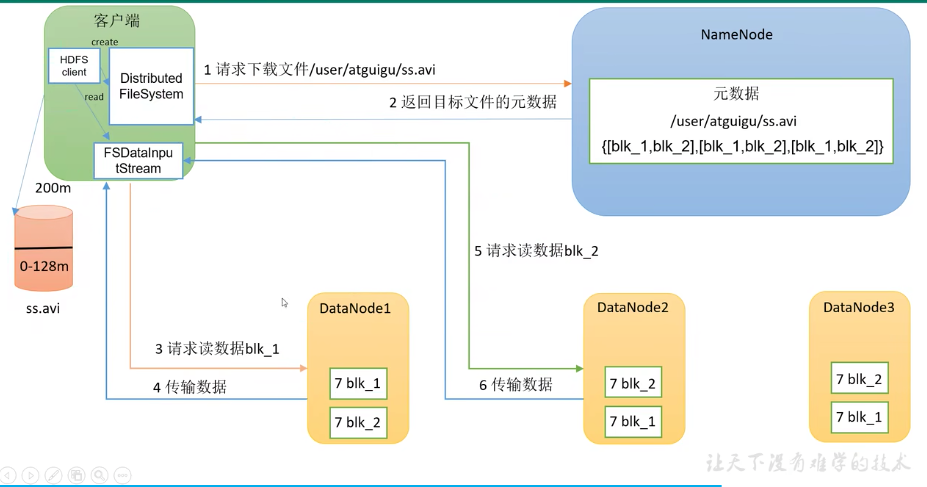

读数据流程

(1)客户端通过DistributedFileSystem向NameNode请求下载文件,NameNode通过查询元数据,找到文件块所在的DataNode地址。

(2)挑选一台DataNode(就近原则,然后随机)服务器,请求读取数据。

(3)DataNode开始传输数据给客户端(从磁盘里面读取数据输入流,以Packet为单位来做校验)。

(4)客户端以Packet为单位接收,先在本地缓存,然后写入目标文件。

五、NameNode和SecondaryNameNode

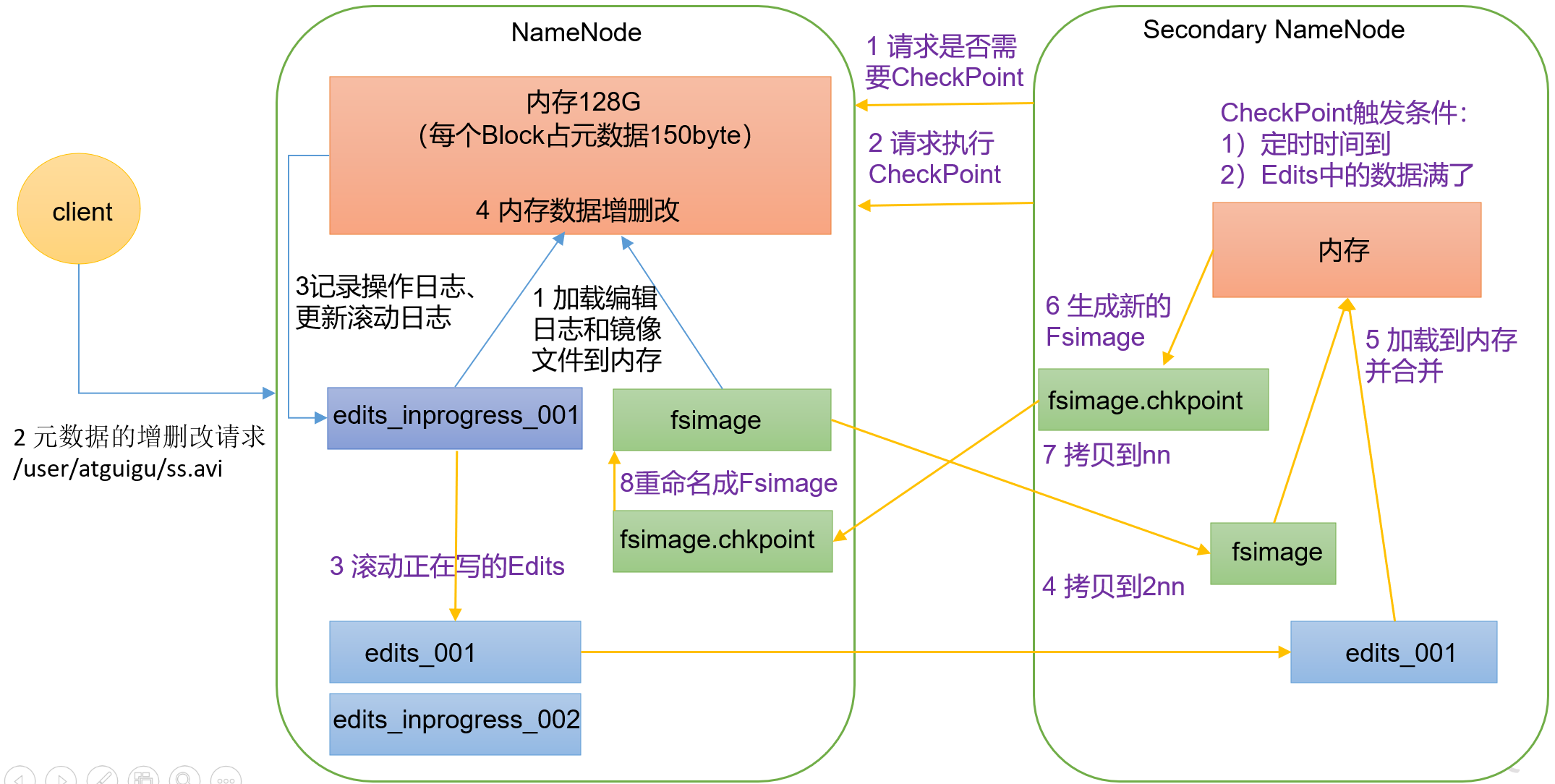

5.1 工作流程

1)第一阶段:NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,直接加载编辑日志和镜像文件到内存。

(2)客户端对元数据进行增删改的请求。

(3)NameNode记录操作日志,更新滚动日志。

(4)NameNode在内存中对元数据进行增删改。

2)第二阶段:Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。直接带回NameNode是否检查结果。

(2)Secondary NameNode请求执行CheckPoint。

(3)NameNode滚动正在写的Edits日志。

(4)将滚动前的编辑日志和镜像文件拷贝到Secondary NameNode。

(5)Secondary NameNode加载编辑日志和镜像文件到内存,并合并。

(6)生成新的镜像文件fsimage.chkpoint。

(7)拷贝fsimage.chkpoint到NameNode。

(8)NameNode将fsimage.chkpoint重新命名成fsimage。

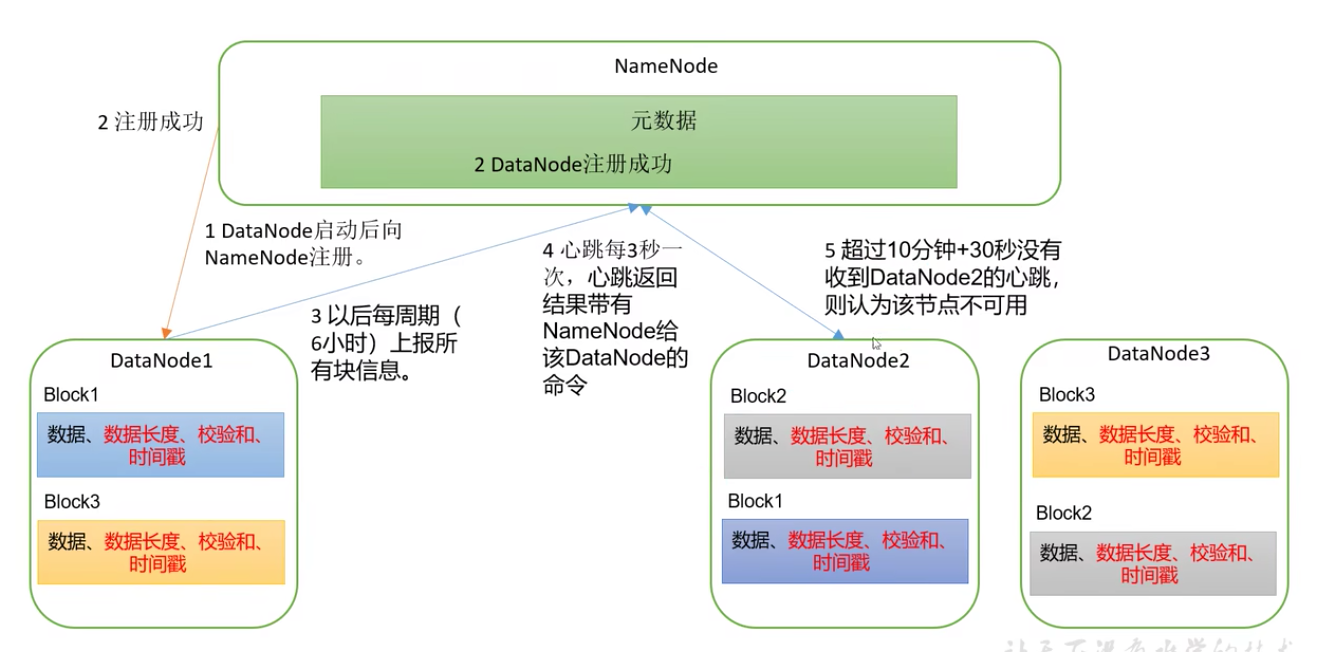

六、Datanode工作机制

(1)一个数据块在DataNode上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据包括数据块的长度,块数据的校验和,以及时间戳。

(2)DataNode启动后向NameNode注册,通过后,周期性(6小时)的向NameNode上报所有的块信息