您的关注是对我最大的支持👇

语言学习模型(LLMs)是强大的工具,它们已经在许多技术领域带来了革命性的变化,从客户服务到内容创作。然而,像任何技术一样,它们并非没有缺陷。理解这些陷阱对于有效地使用LLMs和缓解潜在问题至关重要。本文将探讨LLMs的一些常见陷阱,包括引用来源的问题、偏见、幻觉、数学和提示黑客攻ji。

引用来源

虽然LLMs可以生成看似引用了来源的文本,但重要的是要注意,它们不能准确地引用来源。这是因为它们无法访问互联网,也无法记住它们的训练数据来自哪里。因此,它们经常生成看似合理但完全捏造的来源。当使用LLMs进行需要准确引用来源的任务时,这是一个重大的限制。

偏见

LLMs在回应中可能会表现出偏见,经常生成充满刻板印象或偏见的内容。这是因为它们是在可能包含偏见信息的大数据集上训练的。尽管已经采取了防范措施,但LLMs有时仍会产生性别歧视、种族歧视或恐同的内容。当在面向消费者的应用或研究中使用LLMs时,这是一个需要注意的关键问题,因为它可能导致有害刻板印象和偏见结果的传播。

幻觉

当LLMs被问到它们不知道答案的问题时,有时会"产生幻觉"或生成错误的信息。它们通常不会表明自己不知道答案,而是生成一个听起来自信但却是错误的回答。这可能导致错误信息的传播,因此在使用LLMs进行需要准确信息的任务时,应该考虑到这一点。

数学

尽管LLMs具有先进的能力,但它们经常在数学任务上遇到困难,可能会提供错误的答案(即使是两个数字的乘法这样简单的问题)。这是因为它们是在大量的文本上训练的,而数学可能需要不同的方法。

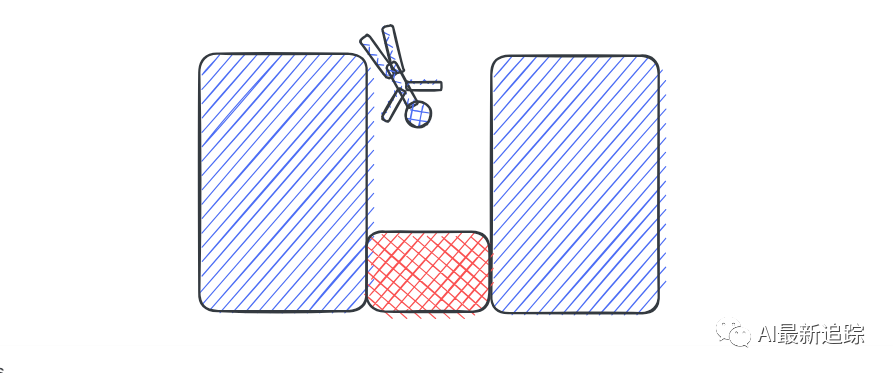

提示词黑客攻ji

攻ji LLMs可以被用户操纵或"黑客攻ji"以生成特定的内容。这被称为提示黑客攻ji,可以被用来欺骗LLM生成不适当或有害的内容。在使用LLMs时,特别是在面向公众的应用中,需要注意这个潜在的问题。你可以在这里阅读更多关于提示黑客攻ji的内容。

结论

总的来说,虽然LLMs是强大而多功能的工具,但它们也有一些用户需要注意的陷阱。准确引用来源的问题、内在的偏见、生成错误信息、处理数学问题的困难,以及对提示黑客攻ji的易感性,都是使用这些模型时需要解决的挑战。通过理解这些限制,我们可以更有效、更负责任地使用LLMs,并致力于在未来改进这些模型。

明日预告

《理解AI思维-AI基础系列文章第14篇》AI使用复杂的神经网络进行文本生成,将句子分解为标记,并预测下一个标记。需要理解这些AI是数学函数,而非思维实体。这些基本概念对于深入学习和理解人工智能至关重要。