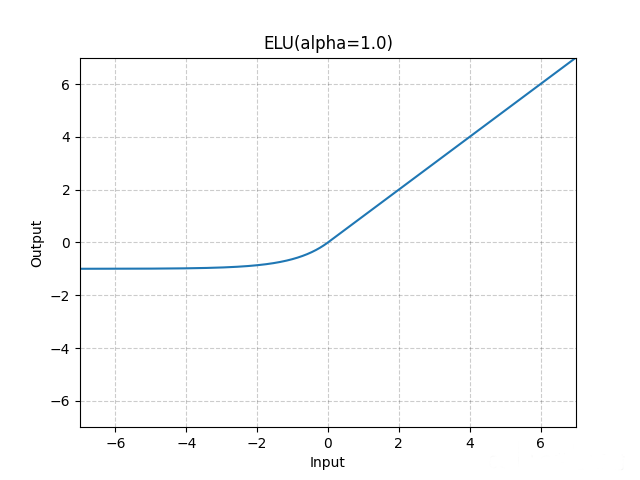

在PyTorch中,torch.nn.ELU代表指数线性单元(Exponential Linear Unit),是一种激活函数。ELU函数可以用来增加神经网络的非线性表达能力,使其具备更强的适应性。

ELU函数的定义如下:

elu(x) = x if x >= 0

alpha * (exp(x) - 1) if x < 0其中,x 是输入,alpha 是一个正数超参数,控制ELU函数在 x < 0 时的负半段斜率。常见的默认值为 alpha = 1.0。

ELU函数在 x >= 0 时返回其本身,而在 x < 0 时采用指数增长的方式进行平滑。

在PyTorch中使用torch.nn.ELU函数可以很方便地将ELU作为激活函数应用到神经网络模型中。以下是一个示例:

import torch

import torch.nn as nn

# 定义一个包含ELU激活函数的全连接层

fc = nn.Linear(in_features=10, out_features=20)

elu = nn.ELU()

# 假设有一批输入张量 x

x = torch.randn(32, 10)

# 使用ELU作为激活函数进行前向传播

output = elu(fc(x))

在这个示例中,我们首先定义了一个具有10个输入特征和20个输出特征的全连接层 fc。然后,我们创建了一个ELU实例 elu。最后,将输入张量 x 通过全连接层和ELU激活函数进行前向传播,得到输出张量 output。

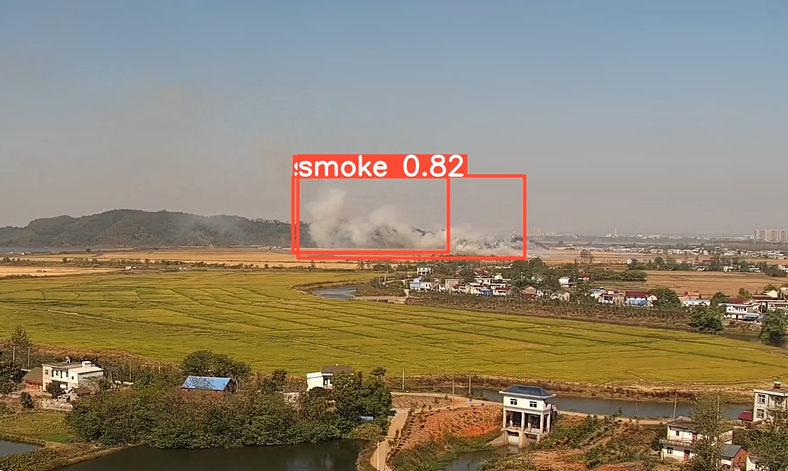

Lnton 羚通视频算法算力云平台专注于音视频算法、算力、云平台的高科技人工智能, 公司基于视频分析技术、视频智能传输技术、远程监测技术以及智能语音融合技术等, 拥有多款可支持 ONVIF、RTSP、GB/T28181 等多协议、多路数的音视频智能分析服务器。