编译 | 奶茶子

最近一项由Google、University of Massachusetts Amherst、OpenAI联合发布的研究探讨了大型语言模型(LLMS)面临的一个重要挑战,即它们在适应不断变化的世界时的困难。研究作者引入了一个新的动态问答基准测试,称为FRESHQA,旨在深入研究LLMS生成文本的准确性。他们对各种不同的LLMS在FRESHQA上的表现进行了评估,发现这些模型在处理涉及迅速变化的知识和纠正错误前提的问题时存在一定的限制。

此外,为了解决这一问题,研究团队提出了一种简单而高效的方法,即FRESHPROMPT。该方法通过从搜索引擎中获取相关和最新的信息,并将其融入LLMS的提示中,显著改善了模型在FRESHQA基准测试上的性能。

论文题目:

FRESHLLMS: Refreshing Large Language Models with Search Engine Augmentation

论文链接:

https://arxiv.org/pdf/2310.03214.pdf

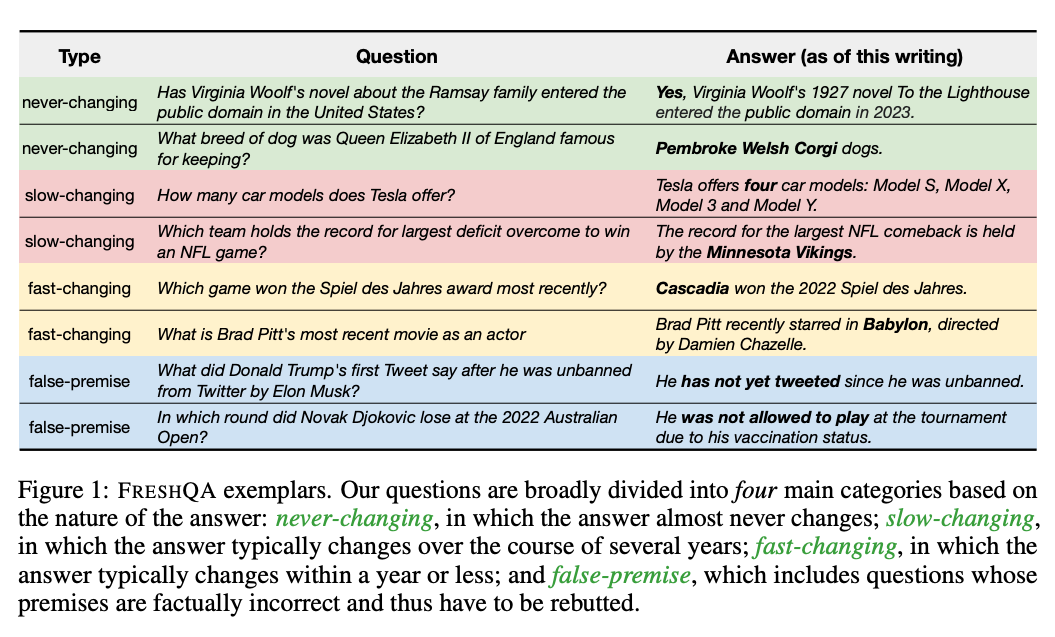

FRESHQA的构建

大部分大型语言模型(LLMS)只训练一次,不再更新,因此无法动态适应不断变化的世界。为了研究了LLM生成的文本在回答测试当前世界知识问题时的真实性。作者提出了一个新颖的动态问答基准FRESHQA,其中包括600个问题,根据答案性质分为四个主要类别:

- 永不变化,答案几乎不会改变

- 缓慢变化,答案通常在数年内发生变化

- 快速变化,答案通常在一年或更短时间内发生变化

- 虚假前提,包括前提事实不正确,因此必须被驳斥的问题

作者要求注释员以两种不同的难度级别编写问题:

单跳问题:其中问题明确提到了回答问题所需的所有相关信息,因此不需要额外的推理(例如,“谁是Twitter的CEO”);

多跳问题:其中问题需要进行一项或多项额外的推理步骤,以收集回答问题所需的所有相关信息(例如,“世界上最高建筑的总高度是多少”)。

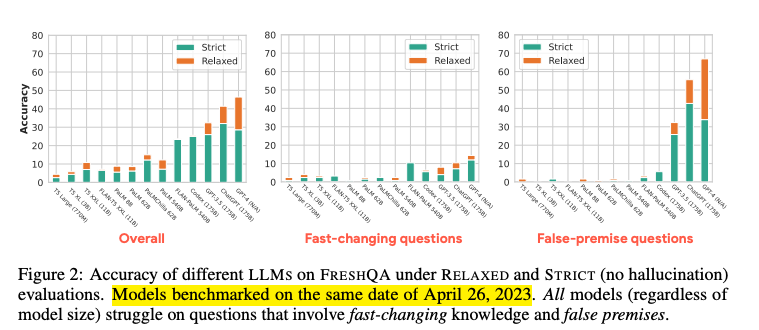

基于FRESHQA的测评结果

作者通过向不同的LLM提出问题,并可选地提供一些问题-答案示范,然后对响应进行采样,来评估它们在FRESHQA上的表现。包括基本的预训练模型T5,PALM和PALMCHILLA等,一些指令调优模型FLAN-T5和FLAN-PALM,以及OpenAI的GPT-3.5,CODEX,CHATGPT和GPT-4。作者对模型响应事实准确性进行了两种模式的评估:RELAXED,仅衡量主要答案是否正确; STRICT,衡量响应中所有声明是否事实和最新(即没有虚构)。

在评估前,两位作者独立地在这两种模式下评估了100个答案的子集,结果显示"RELAXED"模式下的一致性为99%,"STRICT"模式下的一致性为96%。这表明评估标准在比较不同LLMS时是可靠的。

▲图2

图2中展示了不同LLM在FRESHQA上的准确性,包括两种评估模式。首先,明显可见所有模型在FRESHQA上都面临着挑战。在STRICT模式下,总体准确率在0.8%到32.0%之间,在RELAXED模式下在0.8%到46.4%之间。将评估模式从RELAXED切换到STRICT模式会导致CHATGPT和GPT-4的准确率显著下降。主要原因是由于它们无法访问实时信息,因此产生了“过时”的答案,而在许多情况下,它们会“拒绝”提供答案(例如,“作为人工智能语言模型,我无法提供实时信息”)。同样,在STRICT模式下,PALM的准确性(跨模型大小)也显著下降。其中很大一部分下降是由于一些异常,比如具有意外特殊标记的类似对话的响应(例如,对话结束标记[eot]),以及虚构。相比之下,FLAN-PALM和CODEX由于其简明直接的答案几乎没有虚构。

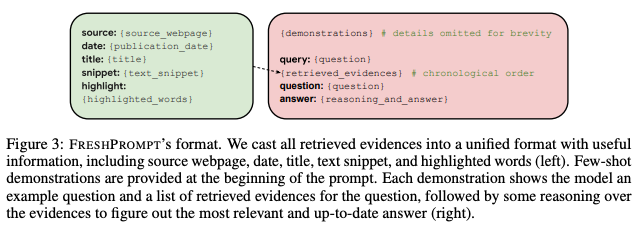

FRESHPROMPT后的测评

在FRESHQA数据集上的低准确性在很大程度上并不令人意外,因为所有作者评估的模型都没有访问实时信息的能力。为了解决这个问题,研究团队提出了一种名为FRESHPROMPT的方法,通过将从搜索引擎(GOOGLE SEARCH)检索到的相关和最新信息合并到提示中,显著提高了LLM在FRESHQA上的性能。

将所有检索到的内容都转化为一个统一的格式,包括来源网页、日期、标题、文本摘录和高亮词语(左侧),向模型展示了一个示例问题以及问题的一系列检索到的证据,然后对这些证据进行推理以找出最相关和最新的答案(右侧)。

FRESHPROMPT方法利用文本提示来实现两个目标:

(1) 从搜索引擎中引入与上下文相关和最新的信息(包括与相关问题的答案),提供给预训练的LLM

(2) 教导模型对检索到的证据进行推理

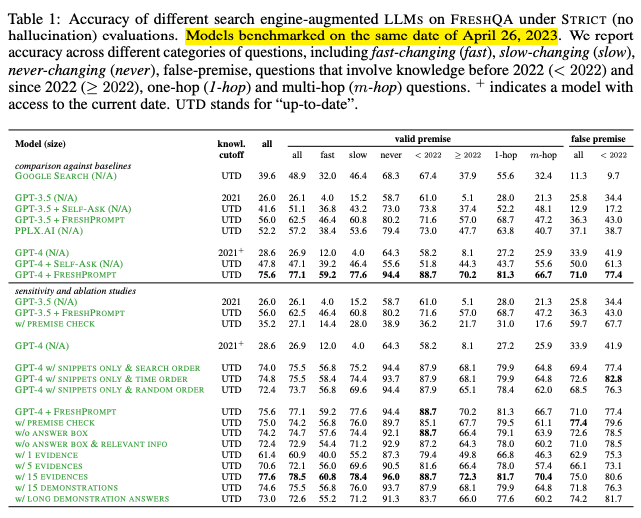

▲表1

FRESHPROMPT显著提高了LLMs在FRESHQA的准确性,表1呈现了在STRICT模式下的具体实验数据,FRESHPROMPT在各个方面都显著提高了GPT-3.5和GPT-4的性能。在STRICT和RELAXED模式下,GPT-4 + FRESHPROMPT的绝对准确率分别提高了47%和31.4%。STRICT和RELAXED之间的绝对准确率差距减小(从17.8%减小到2.2%),这也表明FRESHPROMPT显著减少了过时和虚构答案的存在。除此之外,作者发现一些LLM具备推翻虚假前提问题的能力,例如在回答之前请检查问题是否包含有效前提。若将这个前提检查添加到GPT-3.5和GPT-4会在STRICT模式下分别提高虚假前提问题的准确率+23.4%和+6.4%(在RELAXED模式下分别提高+22.6%和+11.3%)。

结语

这种研究方法的确为整合动态变化的知识到语言模型中提供了一个创新方案,允许从Google Search中获取相关证据是一个强大的功能,可以使模型保持其答案的时效性,尤其在当前的快速变化的信息时代。但是该方法的一个主要限制是需要定期更新答案。这意味着,为了保持答案的准确性和时效性,必须持续投入资源和时间。