还在寻找基于文心一言搭建本地知识库问答的方案吗?AI Studio星河社区带你实战演练(支持私有化部署)!

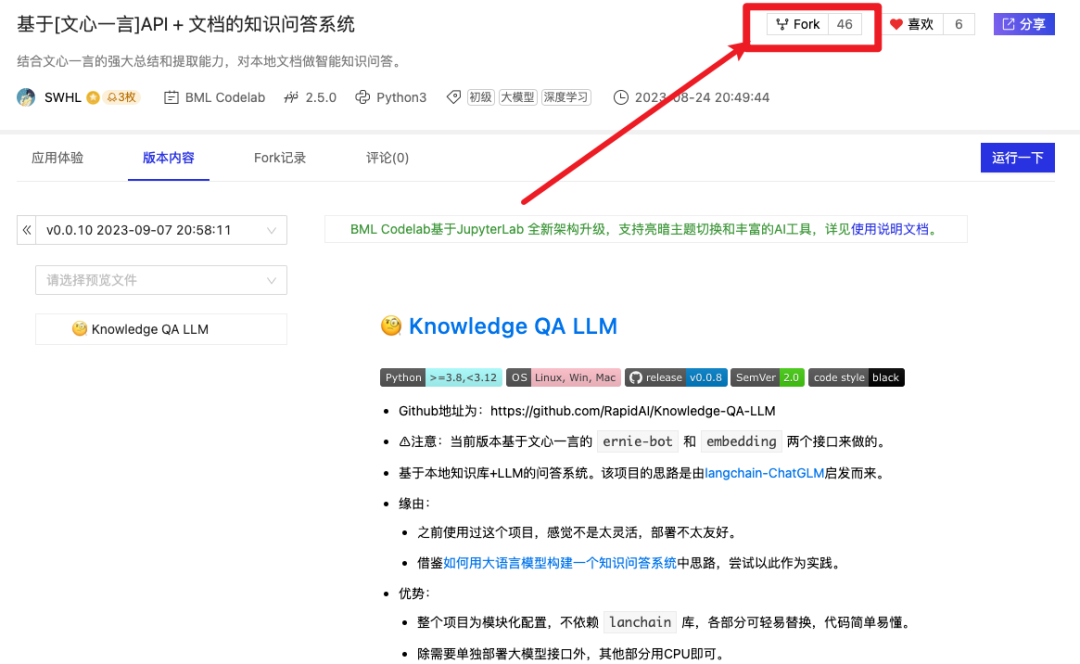

相信对于大语言模型(LLM)有所涉猎的朋友,对于“老网红”知识库问答不会陌生。自从大模型爆火后,开发者都希望尽快进行开发实战,企业都希望尽快在产品中集成LLM的能力,结合业务快速落地,那最直接的方式就是构建知识库问答。本项目由AI Studio星河社区开发者「SWHL」创作并发布体验应用,应用中使用AI Studio SDK(文末获取文档)提供的能力完成文心一言与向量检索增强的结合,与此同时,开发者「SWHL」提供的开源项目还支持本地私有化部署的版本,助力个人和企业完成知识问答系统搭建。

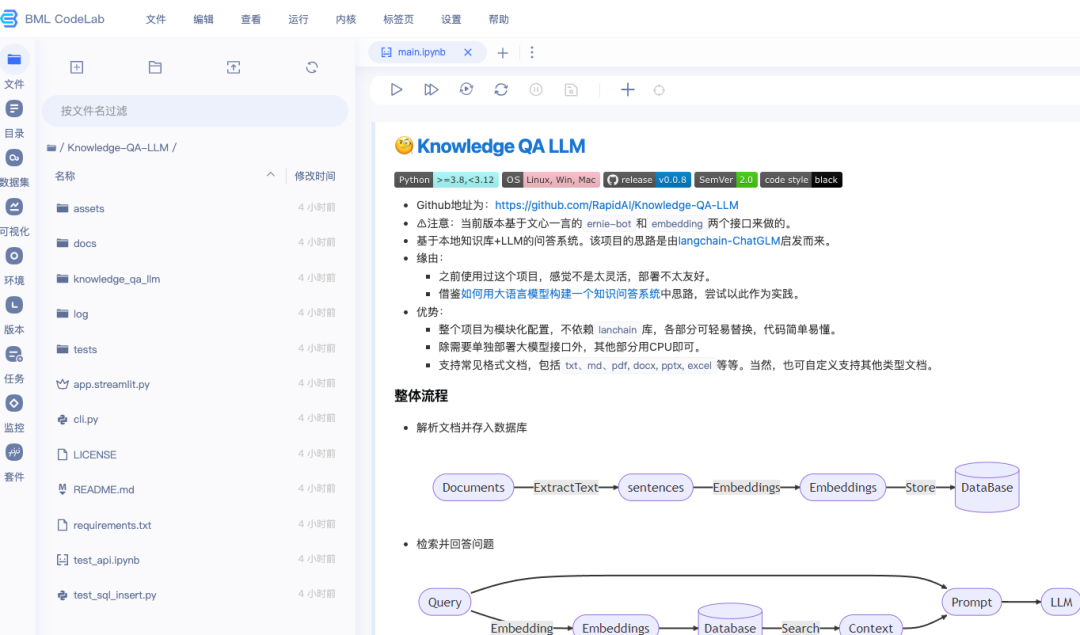

项目亮点

1、除大语言模型接口需要单独部署外,其他部分均可使用CPU

2、整个项目模块化,不依赖lanchain库,各个部分都可以轻松替换,代码简单易懂

3、WebUI向量检索Log可视化

4、支持接入多个LLM模型

5、支持本地私有化部署

应用体验Demo

应用参数解读:

- max_length:生成结果时的最大token数

- top_p:用于控制模型生成文本时,选择下一个单词的概率分布的范围。具体来说,当使用top_p参数时,模型将考虑累积概率分布中概率之和最大的最小集合中的所有单词,并在其中选择下一个单词

- temperature:用于调整模型生成文本时的创造性程度,较高的temperature将使模型更有可能生成新颖、独特的文本,而较低的温度则更有可能生成常见或常规的文本

- Search Top_K:从文档向量数据库中召回的前K个相关内容,用于和问题拼接为完整内容送到大模型中,可选值有5,10, 15

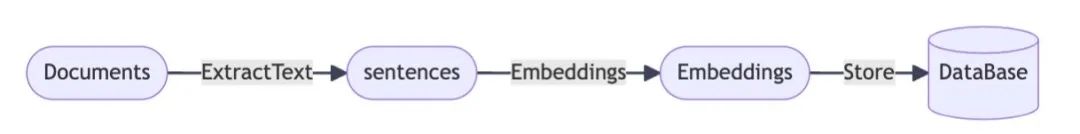

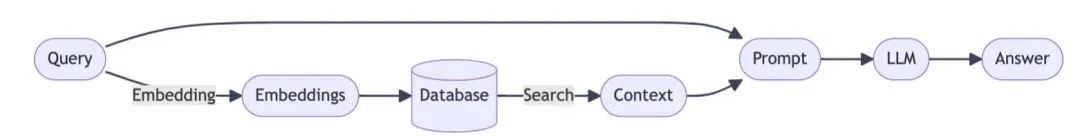

工作流程

1、解析文档并存入数据库

2、检索并回答问题

搭建知识库问答应用

Fork该项目

启动进入线上开发环境

选择CPU环境即可

AI Studio星河社区每周均可免费获得一定数量算力

查看文件进行开发

本地私有化部署

创作者已将该项目进行开源,有私有化部署需求的可移步至该项目Github,获取代码文件进行部署。

项目作者:SWHL,RapidAI开源组织成员,日常研究方向为大模型落地和CV相关,包括OCR和目标检测等方向。

- 作者主页

- RapidAI开源组织主页

- 该项目Github

https://github.com/RapidAI/Knowledge-QA-LLM

AI Studio星河社区已上线SDK开发工具,支持文心一言、Embedding等能力的高效使用。