大家好,我是皮皮。

一、前言

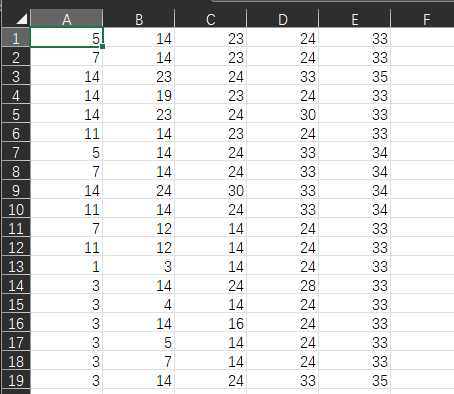

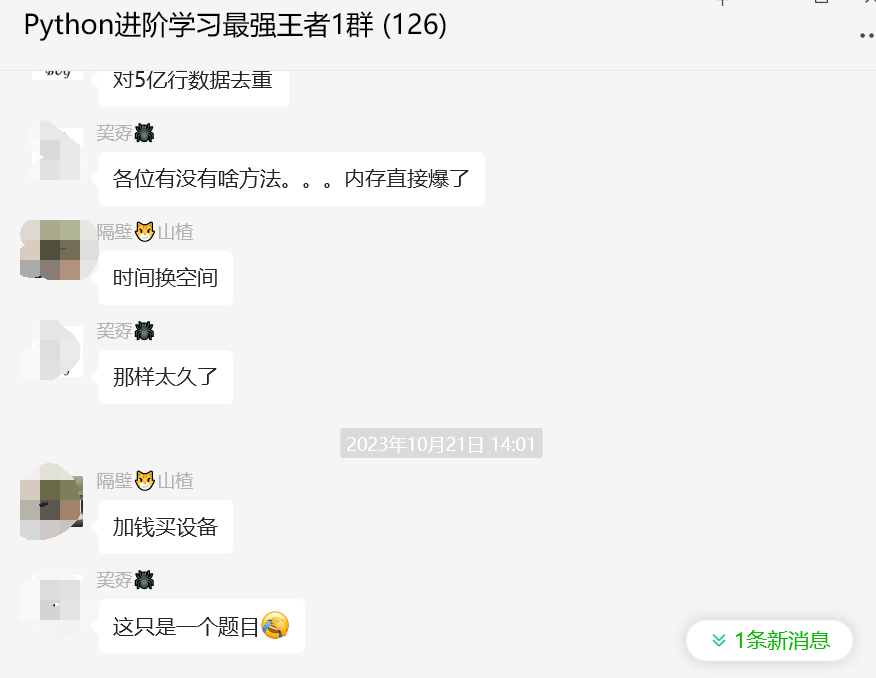

前几天在Python最强王者交流群【巭孬🕷】问了一个问题,一起来看看吧。对5亿行数据去重,各位有没有啥方法。。。内存直接爆了。全是这样的数据,5亿行,按行去重。

二、实现过程

这里【隔壁😼山楂】给了一个思路:如下所示:

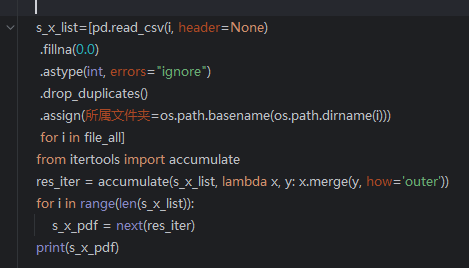

后来【郑煜哲·Xiaopang】给了个思路,全tuple后,set。后来粉丝用merge逐一并集 解决了这个问题。

原来是用concat全部连接起来,再drop_duplicates,直接爆了。

刚才的是去重,算是解决了。现在又有个新问题,下一篇文章我们一起来看看吧。

三、总结

大家好,我是皮皮。这篇文章主要盘点了一个大数据去重的问题,文中针对该问题,给出了具体的解析和代码实现,帮助粉丝顺利解决了问题。

最后感谢粉丝【巭孬🕷】提问,感谢【隔壁😼山楂】、【郑煜哲·Xiaopang】给出的思路和代码解析,感谢【莫生气】等人参与学习交流。

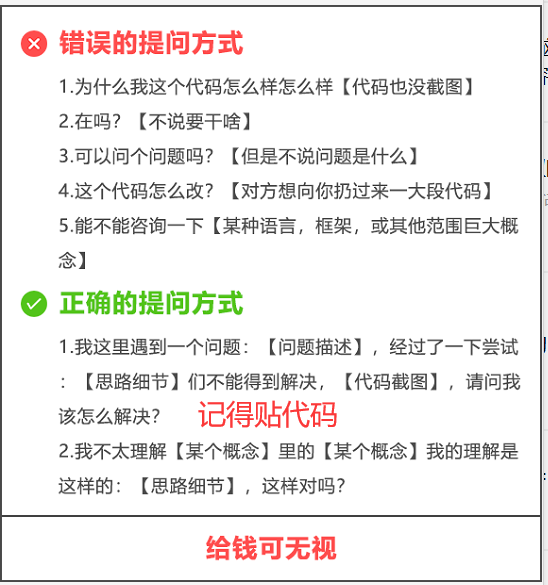

【提问补充】温馨提示,大家在群里提问的时候。可以注意下面几点:如果涉及到大文件数据,可以数据脱敏后,发点demo数据来(小文件的意思),然后贴点代码(可以复制的那种),记得发报错截图(截全)。代码不多的话,直接发代码文字即可,代码超过50行这样的话,发个.py文件就行。